(ZENIT – International Family Studies) Dans un monde où un adulte sur cinq souffre d’un trouble mental chaque année et un enfant sur cinq de dépression, le recours à l’IA semble attrayant. Pourquoi recourir à un thérapeute cher et difficile à trouver quand on peut consulter une IA à qui raconter sa souffrance 24 heures sur 24, 7 jours sur 7 ?

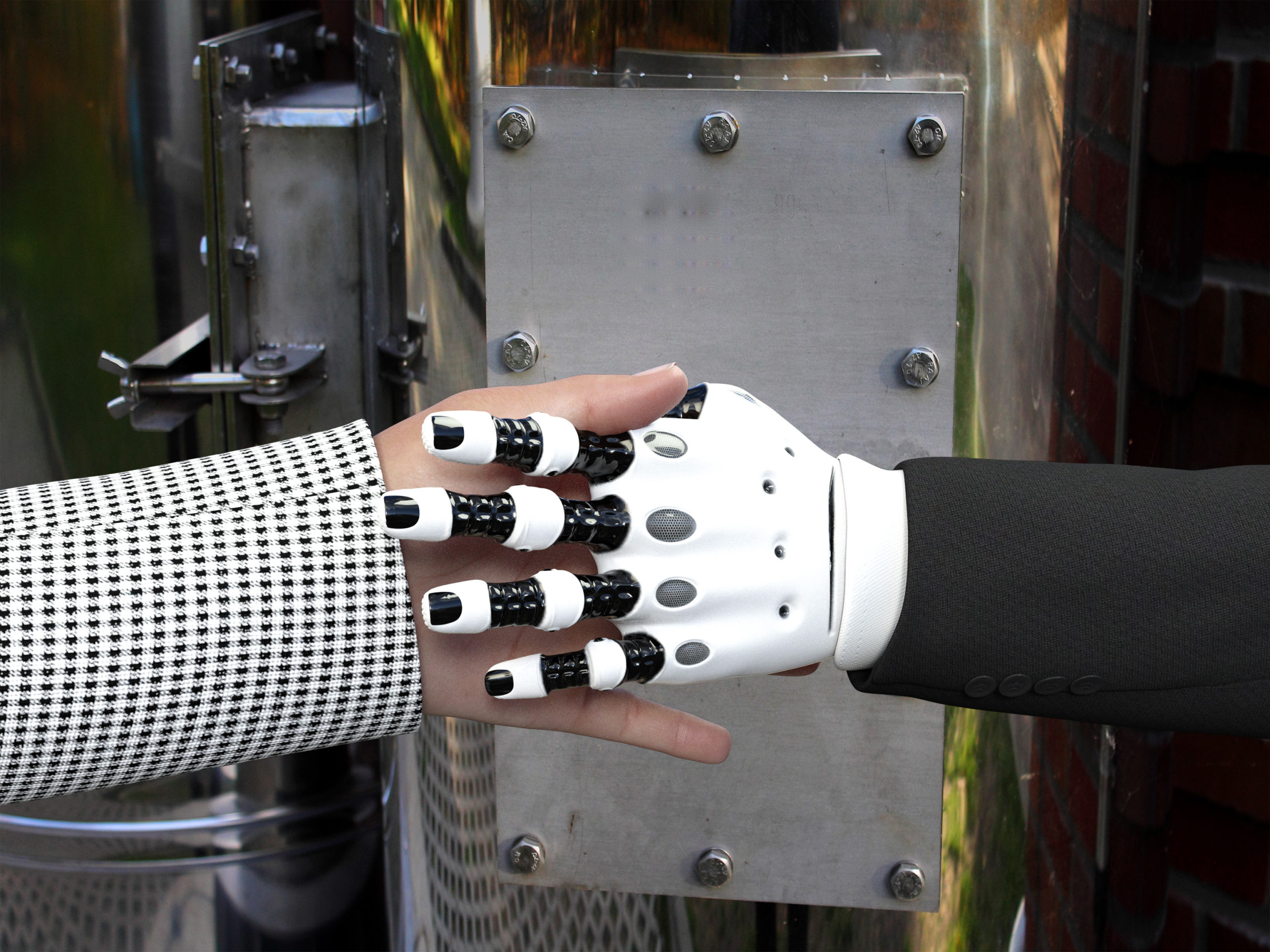

Il est presque impossible d’ouvrir un journal ou d’allumer la télévision sans entendre un commentaire sur les avantages et les dangers que comportent les progrès rapides de la technologie de l’intelligence artificielle (IA). L’émergence de cette technologie a un impact significatif sur un certain nombre de secteurs de l’emploi, créant à la fois des opportunités et des inquiétudes. L’exemple le plus évident est celui du service client, où les chatbots ont tendance à remplacer les personnes en raison de leur efficacité et de leur rentabilité. Toutefois, si ces chatbots traitent efficacement les consultations courantes, ils n’ont pas la capacité de comprendre les questions complexes ou sensibles sur le plan émotionnel. Cette incapacité entraîne souvent la frustration des clients, au risque de nuire à l’image de l’entreprise. Si elle se généralise, l’adoption de l’IA entraînera malheureusement des changements profonds dans le monde de l’emploi, condamnant au chômage de nombreux travailleurs humains qualifiés et aggravant les inégalités économiques.

Mise en garde dans le domaine de la psychothérapie

En tant que psychanalyste, j’estime que l’utilisation la plus courante et la plus risquée de l’IA concerne la psychothérapie. Les personnes qui consultent des chatbots pour remplacer une thérapie encourent des risques importants pour leur santé mentale. Ainsi, au début de cette année, la National Eating Disorders Association (NEDA) a retiré son chatbot, ligne d’assistance supposée remplacer les thérapeutes, parce que les conseils donnés pouvaient être préjudiciables aux utilisateurs : il recommandait par exemple des régimes alimentaires à des personnes souffrant de troubles de l’alimentation. La NEDA, ayant reconnu le risque que les chatbots présentaient pour la santé mentale des patients, a pris les mesures qui s’imposaient.

Prenons l’exemple d’entreprises comme Wysa et Woebot. Wysa propose à ses utilisateurs un chatbot, encore en phase expérimentale, présenté comme un « allié personnel de la santé mentale qui vous aide à vous sentir à nouveau vous-même ». Quant à Woebot, il affirme être « toujours là pour vous aider à surmonter les épreuves ». Dans un monde où un adulte sur cinq souffre de troubles mentaux chaque année et où un enfant sur cinq de dépression, le recours à l’IA semble séduisant : pourquoi rechercher un thérapeute coûteux et difficile à trouver quand on peut consulter une IA qui écoute votre douleur 24 heures sur 24, 7 jours sur 7 ? De fait, des applications telles que Wysa et Woebot peuvent remplir des fonctions utiles, notamment en proposant des exercices comportementaux et d’auto-apaisement personnalisés, à l’instar d’une application de pleine conscience, capables de soulager la détresse momentanée d’un utilisateur donné. Mais elles ne remplacent pas le contact humain.

Pour tenter de mieux comprendre Woebot, je suis allée sur Internet afin de juger par moi-même des avantages et des risques. Ce que j’ai découvert est vraiment inquiétant. Si un utilisateur lui dit « je me sens triste », Woebot est incapable d’évaluer correctement le niveau de tristesse de l’utilisateur et son impact sur sa vie quotidienne. En effet Woebot ne sait pas identifier les indices sociaux et physiques ni les types de comportements des personnes souffrant de dépression, qui lui permettraient d’évaluer leur autonomie : par exemple si elles n’ont pas pris de douche depuis plusieurs jours, si elles sont voûtées ou si elles ont du mal à établir un contact visuel. Par essence, l’IA ne peut pas percevoir les nuances du processus d’évaluation thérapeutique. En d’autres termes, Woebot n’a pas la fonction cérébrale droite d’un psychothérapeute, celle qui lui permet de lire les signaux sociaux et de comprendre les émotions en prenant en compte des facteurs tels que le langage corporel, le ton de la voix ou les larmes. Woebot ne peut pas saisir la complexité profondément personnelle de la maladie mentale que seule une véritable relation thérapeutique peut permettre de percevoir, à travers l’histoire des réussites et des échecs d’une personne ou à travers ses relations avec ses amis, ses supérieurs hiérarchiques et sa famille. A mesure que la technologie progresse, que l’interactivité s’améliore, que ces produits sont commercialisés comme « substituts de thérapie », le risque s’accroit. L’utilisation de l’IA à cette fin est une source légitime de préoccupation.

Une relation personnelle nécessaire entre le professionnel et son patient

En tant que thérapeute, je peux avoir, certes, des préjugés sur l’IA. Cependant, grâce à ma formation et à mon expérience dans le domaine de la psychanalyse, j’ai pu constater qu’une relation personnelle et authentique entre le psychothérapeute et son patient est une composante nécessaire à une psychothérapie efficace. Or un chatbot ne peut offrir cette relation. De nombreuses personnes suivent une psychothérapie en raison de difficultés relationnelles, qui ne peuvent être corrigées que par le développement d’une relation bienveillante et empathique avec une autre personne. La formation d’une relation artificielle avec un thérapeute virtuel, une interface synthétiquement compatissante, n’est pas une voie vers la santé mentale. La superficialité des réponses de l’IA peut même faire régresser les patients. En outre, l’attachement à l’IA sera contre-productif à partir du moment où les utilisateurs se rendront compte que le contact reste illusoire, qu’il ne s’agit que d’une machine et non d’une personne, et cela au moment où l’IA est prise en défaut ou lorsque sa « personnalité » est soudain actualisée. Cette prise de conscience peut provoquer une profonde détresse et une grande confusion chez le « patient d’une interface d’IA.

Risque de conseils inadaptés ou peu nuancés

Ces chatbots peuvent également être contre-productifs en offrant des conseils qui ne correspondent pas aux besoins du patient. Tessa, le chatbot abandonné par la NEDA, offrait aux utilisateurs des conseils préconçus, et aussi des régimes dévastateurs pour des personnes souffrant de troubles de l’alimentation. La façon dont je me comporte avec mes patients est filtrée par mon cerveau droit, siège de l’intelligence émotionnelle, capable de percevoir les nuances, lire intuitivement les signaux sociaux et m’aider à comprendre comment guider respectueusement mes relations avec les patients sans leur nuire. En tant que thérapeute, j’ai une grande influence sur mes patients, et même si une IA n’a pas d’intention malveillante, le manque d’empathie humaine authentique peut, par inadvertance, la conduire à mal orienter ses utilisateurs, à leur donner des conseils inadaptés, ou peu nuancés, qui risquent d’être mal interprétés.

Mieke De Ketelaere, professeur à la Vlerick Business School, est l’une des expertes belges des aspects éthiques, juridiques et durables de l’IA. Dans une lettre ouverte, elle met en garde : « dès que les gens ont le sentiment d’interagir avec une entité subjective, ils créent un lien avec cet « interlocuteur » – même inconsciemment – qui les fragilise et peut porter atteinte à leur autonomie ». Les patients souffrant de dépression et d’anxiété sont particulièrement vulnérables et susceptibles d’être manipulés par ces applications, notamment « ceux qui ne disposent pas d’un réseau social solide, ou ceux qui se sentent seuls ou déprimés, précisément la catégorie qui, selon les créateurs des chatbots, peut tirer le plus de bénéfices de ces systèmes ». En d’autres termes, si vous êtes seul, avide de contacts, peut-être déprimé et très influençable, l’IA peut exercer sur vous une influence considérable quant à la prise de décision, le contrôle de soi et les émotions.

L’IA peut se substituer à de nombreuses professions et capacités humaines, mais les professionnels de la santé qui travaillent avec des concepts aussi complexes que la maladie ne peuvent et ne doivent pas être remplacés par un chatbot. Tenter de le faire est dangereux et peut avoir de graves conséquences éthiques et pour la santé mentale.

Erica Komisar, LCSW, est psychanalyste et auteur de Being There : Why Prioritizing Motherhood in the First Three Years Matters et de Chicken Little The Sky Isn’t Falling : Raising Resilient Adolescents in the New Age of Anxiety.